Mise en place d'une infrastructure Docker Swarm

Frédéric Minne - Université catholique de Louvain

Travail réalisé dans le cadre d'un brevet pour l'obtention du barème d'informaticien expert.

This work is licensed under a Creative Commons Attribution 4.0 International License.

This work is licensed under a Creative Commons Attribution 4.0 International License.

Plan

- Introduction : présentation générale du contexte et du périmètre de ce travail

- Docker, Docker Swarm et les infrastructures à base de conteneurs : introduction technique à Docker et au mode Swarm

- Mise en place d'une infrastructure de démonstration : documentation et enseignements de la mise en place d'une infrastructure de démonstration

- Déploiement d'applications et livraison continue : recettes de déploiement d'applications, livraison continue avec gitlab, gitlab-ci et docker

- Perspectives : considérations et recommendations pour le passage en production d'une infrastructure Docker Swarm

- Conclusion : conclusion et propositions pour le futur

- Bibliographie et ressources

- Annexes : éléments complémentaires et anciennes versions de l'infrastructure

Introduction

Contexte et enjeux

Apparues au début des années 2000, les infrastructures à base de conteneurs sont devenues un des outils clés de l'informatique moderne. Cette tendance a encore été renforcée par le développement des infrastructures dans le cloud qui supportent de plus en plus souvent le déploiement de conteneurs. On constate donc une multiplication de l'usage des conteneurs, et cette demande en termes de conteneurs va sans doute encore augmenter dans les prochaines années.

Une multiplication de l'usage des conteneurs

Qu’il s’agisse d’applications mises en place au sein des services informatiques ou dans le cadre de projets de recherche ou de fin d'études (mémoires de master…), les demandes pour des infrastructures à base conteneurs se multiplient à l'UCLouvain. Citons par exemple : les infrastructures web pour le nouveau portail web UCLouvain en Drupal (SISG), l'infrastructure elastic search pour le service des bibliothèques (BIB et SISG), l'infrastructure pour DIGIT (SIPS)...

Par ailleurs ce recours de plus en plus fréquent aux conteneurs dans le monde académique ou scientifique n'est pas le monopole de l'UCLouvain et se rencontre dans de nombreuses institutions. L’un des domaines concernés est la mise en place d’infrastructure pour les outils TICE. Les conteneurs sont d'ailleurs devenus un sujet récurrent du JIRES1.

A cela s’ajoute une utilisation de plus en plus fréquente des conteneurs pour la mise en place d’environnements de développement local, que ce soit avec un outil générique comme Docker Compose2 ou avec des solutions spécifiques comme ddev3 pour les applications PHP\MySQL. Il serait dès lors intéressant de pouvoir déployer en production les applications développées au sein des différentes équipes avec les mêmes technologies utilisées par les équipes de développement.

Mais au-delà du développement d'application, les conteneurs permettent aussi un déploiement d'applications pré-configurées (configuration as code), l'upgrade plus sûr des applications en production, des cycles de release plus courts (voire de l'intégration continue)...

De nombreuses applications proposent donc des procédures de déploiement basées sur les conteneurs, par exemple Ceph qui utilise l'orchestrateur Podman pour déployer son cluster, et les compétences dans ce domaine vont devoir se développer au sein des équipes.

Des applications aux besoins variés et plus complexes à mettre en production

De petites applications métier disponibles en ligne sont développées et mises en place afin de rendre des services à l’ensemble des informaticien·ne·s et autres usager·e·s de l'UCLouvain :

- Hébergement d'applications web.

- Applications métier.

- Outils de développement ou de collaboration.

- Outil de gestion des groupes.

- Valves électroniques...

La plupart de ces applications sont développées sur base de technologies et d'environnements d'exécution variés, avec de nombreux impacts pour les équipes qui les gèrent :

- Elles dépendent souvent de versions différentes d’un même langage de programmation ou d'un environnement d'exécution dont la coexistence sur une même machine est problématique.

- Elles nécessitent des versions différentes de services tiers et qui doivent cohabiter sur une même machine (virtuelle le plus souvent)

- Elles sont parfois mal isolées les unes des autres et une faille de sécurité dans une d’entre elles peut compromettre toute la machine qui les héberge

Tout cela peut causer des difficultés lors de l’installation, de la maintenance ou de la configuration des machines d’hébergement et entraîner une consommation parfois inutile de ressources. De plus cela impose souvent de multiplier les machines virtuelles pour les héberger.

L'ère des applications monolithiques est aujourd'hui révolue. La plupart des applications modernes se basent sur une pile applicative constituée de nombreux services (base de données, authentification, environnement d'exécution, service de cache, mailing...) séparés et uns des autres. Cela multiplie les applications à déployer et à maintenir.

Parmi les solutions ont été proposées au fil des années, les technologies de conteneurs (la plus connue étant Docker) répondent à ces enjeux. Elles permettent de déployer et de faire coexister des environnements d’exécution hétérogènes très facilement sur une même machine4. Elles permettent un meilleur contrôle de l’isolation entre ceux-ci et facilitent leur déploiement et leur mise à jour. Elles permettent également une répartition de la charge sur plusieurs machines hôtes. Enfin, elles facilitent le déploiement des applications à partir de fichiers de configuration de piles applicatives.

Ce type d'infrastructure à base de conteneurs pourrait également être déployé dans le cadre d'un hébergement web qui, par nature, est hétérogène et utilise une grande variété de technologies.

Contenu et délivrables du brevet

Afin d'explorer les possibilités des conteneurs et de constituer une base pour développer les compétences des équipes intéressées par ce type d'infrastructure (équipe système, portail...), il s’agira dans ce brevet d’étudier et d’expérimenter la mise en place d’une infrastructure à base de conteneurs. Comme point de départ, j'ai envisagé une infrastructure qui pourrait succéder à l’infrastructure « webapps » actuelle de SISG5,

Au-delà de cette infrastructure proprement dite, il s'agira également de tester des outils permettant l'automatisation des tâches de gestion de l’infrastructure et de déploiement d’applications sur celle-ci.

Il s’agira également d’examiner les perspectives quant à la mise en production d’une telle infrastructure.

Les délivrables sont :

- La mise en place d’une infrastructure de démonstration basée sur Docker pour l’hébergement et le développement d’applications web et qui a servi de base à mon travail.

- Une documentation (le présent document) décrivant la mise en place de l’infrastructure, les étapes nécessaires pour la répliquer ou la reconstruire et les outils permettant d’en automatiser les tâches de gestion. Y sont également abordées les questions relatives à la mise en production d’une telle infrastructure et au déploiement d’applications sur celle-ci.

- Les fichiers techniques (scripts, fichiers de configuration, description des machines virtuels, fichiers images docker…) nécessaire à la mise en place de l'infrastructure et au déploiement d’applications web seront également mis à disposition.

La documentation et les fichiers techniques sont mis à disposition dans un dépôt Gitlab sur la forge institutionnelle.

Organisation du présent document

Dans la première partie de ce document, je donnerai une rapide introduction technique à Docker afin de fournir les bases nécessaires à la compréhension des chapitres suivants. Sa lecture est optionnelle pour les lecteurs ayant déjà utilisé Docker et Docker Swarm.

Dans un second temps, j'aborderai la mise en place d’une infrastructure de démonstration basée sur l'orchestrateur Docker Swarm. La forme que j'ai choisie est celle d'un mode d'emploi, afin de permettre à toute personne intéressée de pouvoir déployer une telle infrastructure.

Dans la troisième partie, je proposerai des solutions pour automatiser le déploiement de cette infrastructure ainsi que des outils permettant de faciliter sa gestion. Il s’agira aussi de décrire la manière dont les applications peuvent être déployées sur cette infrastructure.

Dans la quatrième partie, j'aborderai les perspectives liées à la mise en production de cette infrastructure et au changement technologique qu'elle implique. Il s'agira également de décrire comment le travail réalisé dans la deuxième partie pourra être transcrit en production. J’aborderai enfin quelques pistes pour l'avenir des infrastructures à base de conteneurs à l'UCLouvain.

Il sera alors temps pour moi de conclure et de remettre en contexte le travail réalisé.

Journées Réseaux de l’Enseignement et de la Recherche, organisées tous les deux ans en France https://www.jres.org/fr/

Docker Compose est un orchestrateur pour Docker et facilite le déploiement et la gestion de conteneur Docker sur une machine https://docs.docker.com/compose/

Développé au départ pour faciliter le développement de site Drupal, ddev est une suite d'outil automatisant le déploiement local de pile applicative PHP/MySQL (Wordpress, Drupal, Symfony...) https://ddev.com/

Il est également possible d’utiliser les technologies de conteneur afin de déployer des versions différentes d’un même environnement d’exécution sur une même machine d’hébergement. Il peut s’agir de versions différentes d’un langage de programmation (par exemple PHP 7.0, 7.2, 7.4, 5.6...) ou d’une même version mais avec des modules complémentaires différents. Voir par exemple « Utilisez plusieurs versions de PHP sur un même serveur web » publié dans le numéro 115 de Linux Pratique, sept-oct 2019

actuellement l’hébergement des « webapps » se fait sur l'infrastructure de l'hébergement institutionnel.

Docker, Docker Swarm et les infrastructures à base de conteneurs

- Conteneurs et machines virtuelles deux approches de la virtualisation

- Docker

- Docker Compose

- Docker Swarm

Conteneurs et machines virtuelles deux approches de la virtualisation

Ces 10 dernières années, la virtualisation d’infrastructure informatique, jusqu’alors dominée par les machines virtuelles, a connu un grand changement, et les technologies basées sur les conteneurs sont devenues un incontournable pour de nombreuses applications : développement, hébergement d’application web, calcul intensif, IoT, déploiement d’applications…

Si l’on peut faire remonter l’origine des mécanismes d’isolation de conteneurs à la commande chroot introduite en 1982 dans les systèmes UNIX, c’est au début des années 2000 que cette technologie va prendre sa forme actuelle avec des solutions telles que Linux-VServer (2000), Free BSD Jail (2000), OpenVZ (2005) ou Solaris Containers (2004)1.

Introduite en 2013, Docker n’est pas la seule solution de conteneur existant sur le marché, mais elle reste l'une des plus populaires. Parmi ses concurrents, on peut citer LXC (pour Linux Container) et son successeur LXD (Linux Container Daemon), CoreOS rkt (ou simplement Rkt), OpenVz, Apache Mesos, Podman ou encore containerd.

Devant ce grand nombre de solutions, l'Open Container Initiative (OCI) de la Linux Foundation définit des spécifications afin de garantir l’interopérabilité entre les solutions à base de conteneurs. Elle a défini des spécifications pour le format d’image OCI image-spec le l’environnement d’exécution runtime-spec – basé sur runC développé initialement par Docker.

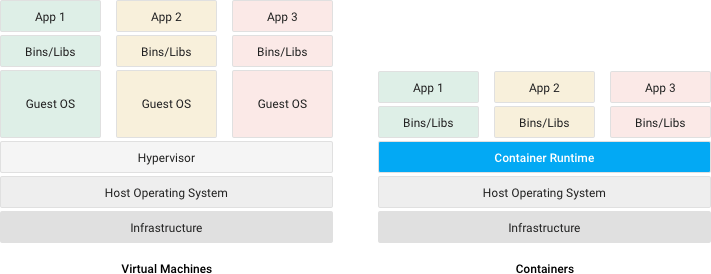

Conteneurs et machines virtuelles : quelles différences ?

Conteneurs et machines virtuelles sont deux solutions de virtualisation d’infrastructure informatique et permettent d’isoler le fonctionnement d’un programme, donnant l’impression qu’il s’exécute dans un environnement dédié2.

- Une machine virtuelle (VM) virtualise le hardware afin d’exécuter un système d’exploitation complet qui permettra lui-même l’exécution des programmes. Un hyperviseur3 permet alors de contrôler les différentes VM sur une machine hôte.

- Un conteneur (ou conteneur d’application) virtualise uniquement un système d’exploitation qui permettra l’exécution des programmes. Un moteur de conteneurs permet alors de contrôler les différents conteneurs sur une (ou plusieurs) machine·s hôte·s.

Illustration : Différences entre conteneurs et machines virtuelles – source : documentation du cloud Google

Les infrastructures « cloud » peuvent mettre en œuvre ces 2 mécanismes pour déployer les applications : des machines virtuelles déployées sur un hyperviseur vont servir d’hôtes pour un environnement d’exécution de conteneurs tel que Docker.

Dans les deux cas (machine virtuelle ou conteneur), un orchestrateur peut-être utilisé pour gérer l’infrastructure :

- Un orchestrateur de machines virtuelles (Vagrant, Open Nebula, Open Stack…) permet de gérer un ou plusieurs hyperviseurs (KVM, Virtualbox, VMWare...) et d'y déployer des machines virtuelles.

- Un orchestrateur de conteneurs (Docker Compose, Docker Swarm, Kubernetes, Podman, Amazon ECS, Azure Container Service…) permet de déployer et de gérer les conteneurs sur plusieurs systèmes hôtes.

Note : Certains orchestrateurs comme Vagrant, Open Nebula ou Terraform permettent de gérer tant des VM que des conteneurs.

Avantages et limites des conteneurs

Les conteneurs offrent des avantages par rapport aux machines virtuelles. En voici quelques uns :

- Abstraction : les conteneurs suppriment la dépendance envers l’infrastructure et le besoin d'interagir directement avec le système hôte.

- Automatisation et portabilité : les conteneurs facilitent l’automatisation des tâches (déploiement, mise à jour…) et augmentent ainsi la portabilité des applications.

- Sécurité et isolation : la sécurité des applications conteneurisées (isolation, réseau, pare-feu, accès aux données…) est gérée au niveau de la plateforme, en dehors des conteneurs, ce qui réduit fortement la complexité de leur mise en œuvre. De plus, chaque conteneur s’exécute dans un environnement isolé des autres réduisant ainsi l’impact d’un problème.

- Déploiement sur le cloud : la portabilité des conteneurs et la division des applications en services indépendants permet un déploiement facilité dans le cloud.

- Usage réduit des ressources système : les conteneurs constituent une solution de virtualisation plus légère et avec moins de perte de performances que les machines virtuelles.

- Cycle de vie des applications : les conteneurs facilitent et accélèrent le cycle de vie des applications du développement au déploiement en production. Ils facilitent en particulier le déploiement et la mise à jour de piles applicatives sur un cluster ou sur un grand nombre de systèmes en parallèle (par exemple pour l'IoT).

- Architecture en micro-services : légers et portables, les conteneurs simplifient la mise en place d’infrastructure en micro-services4.

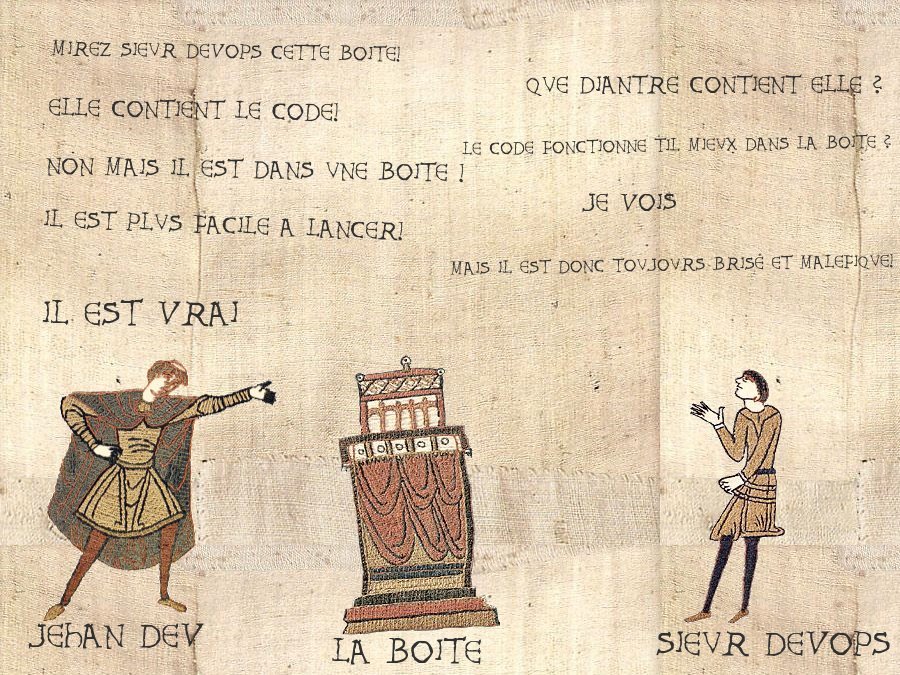

Mêmes s’ils peuvent fortement faciliter leur travail, les conteneurs ne sont pas la solution miracle à tous les problèmes d’un sysadmin ou d’un développeur !

Bien qu’ils isolent les applications entre elles et réduisent ainsi les dangers pour l’infrastructure dans son ensemble, les conteneurs ne résoudront pas les problèmes de sécurité d’une application ! Si une faille permet d’exposer, par exemple, les données des utilisateurs d’un CMS, ce sera toujours le cas dans une infrastructure en conteneurs. En d’autres termes, une application mal écrite restera une application mal écrite même si elle s’exécute dans un conteneur.

Illustration : Isolation d’une application mal écrite dans un conteneur, mème humoristique inspiré de la tapisserie de Bayeux, auteur inconnu

De même, s’ils facilitent la mise en place de micro-services, les conteneurs ne transformeront pas magiquement une application monolithique en micro-services ! Cela requiert un travail au niveau du design des applications elles-mêmes.

Malgré un mythe persistant, les conteneurs ne peuvent remplacer les machines virtuelles dans tous les cas ! Ils fournissent par exemple moins d’isolation que les machines virtuelles, puisque les conteneurs s’exécutent quand même dans un même système hôte. Si l’isolation d’un système est cruciale, une machine virtuelle reste donc préférable. Là où les conteneurs se révèlent intéressants, c’est qu’ils permettent facilement de mieux isoler entre elles des applications qui s’exécutaient déjà sur un même hôte.

Une autre limitation des systèmes de virtualisation à base de conteneur est que, comme ils opèrent au niveau du système d’exploitation et pas du hardware, il n’est pas possible d’exécuter des conteneurs avec un système d’exploitation différent de celui de leur hôte. Ainsi sous Linux, seuls des conteneurs Linux peuvent être exécutés. Il est toutefois possible d’exécuter des distributions Linux différentes de celle du système hôte, par exemple des conteneurs Debian ou CentOS peuvent sans problème s’exécuter sous Ubuntu, et de même une machine Ubuntu 18.04 peut sans problème exécuter d’autres versions même plus récentes d’Ubuntu. Déployer des conteneurs Linux sous MacOSX ou Windows nécessite donc une machine virtuelle Linux.

Ajoutons à cela que la majorité des solutions de virtualisation à base de conteneurs sont disponibles sous Linux uniquement, puisqu’elles se basent pour la plupart sur les mêmes mécanismes du noyau Linux.

Docker

Pourquoi choisir Docker ?

J'ai choisi Docker pour mon infrastructure pour les raisons suivantes :

- Répandu : Même s’il ne consiste pas le seul environnement d’exécution de conteneur disponible, Docker est de loin le plus populaire et le plus utilisé.

- Standard : Poussé par de grands acteurs comme Google, RedHat ou encore Ubuntu, supporté par le cloud Amazon ou Azure, Docker reste encore un standard de facto pour les infrastructures à base de conteneurs.

- Support : La société Docker Enterprise (rachetée par Mirabilis en 2019) offre du support et des services professionnels autour du Docker Engine.

- Multi-plateforme : Docker propose un environnement d’exécution (Docker Engine) disponible sur la plupart des plateformes (Linux, MacOS X et Windows) via Docker Desktop. Toutefois, l'installation serveur du Docker Engine ne fonctionne que sous Linux pour les conteneurs Linux ou Windows pour les conteneurs Windows. Dans tous les autres cas une VM Linux est requise.

- Multi-architecture : Docker est disponible pour diverses architectures matérielles et peut être déployé tant sur des serveurs que sur de l'IoT.

- Large écosystème : Docker fournit et supporte un large écosystème d’outils qui facilitent grandement le travail des informaticiens qu’ils soient administrateurs système, développeurs, packageurs d’application… Docker est de plus intégré comme backend à de nombreux outils : orchestrateurs (Vagrant), plateformes de CI/CD (Gitlab), outils d’automatisation (Ansible)

- Disponibilité d’applications : De nombreuses applications web sont déjà prêtes à être déployées avec Docker via l’outil

docker compose. Des générateurs de configuration sont également disponibles sur le web. - Orchestrateurs : Des outils d’orchestration de parcs informatiques compatibles Docker sont déjà disponibles comme Kubernetes, Rancher, OpenShift… mais Docker lui-même intègre ses propres orchestrateurs permettant le déploiement sur un cluster via Docker Swarm ou sur une machine locale avec Docker Compose.

- Portabilité dans le cloud : Les conteneurs Docker peuvent être déployés dans le cloud (Azure, Amazon AWS) ou sur des « nano-ordinateurs » (Raspberry Pi, Olimex…) afin de mettre en place des solutions IoT (Internet of Things).

- Communauté et documentation : Docker a une large communauté et une grande quantité de documentation (sites web, livres, MOOCS, tutoriels…) est disponible. La documentation officielle est extrêmement complète et est fréquemment mise à jour.

Les technologies derrière Docker

Comme plusieurs autres technologies de conteneurs telles que LXC5, Docker se base sur des mécanismes et services de base du noyau Linux afin d’isoler les applications :

cgroups(control groups) assure la distribution des ressources du système hôte.namespaceassurent l’isolation des processus entre eux.containerdfournit des services nécessaires pour le fonctionnement des conteneurs.

Comme je l'ai déjà évoqué plus haut, Docker est donc une technologie intrinsèquement liée à Linux et ne peut s’exécuter sur les autres systèmes d’exploitation qu’à condition de passer par une machine virtuelle exécutant Linux. Il y a toutefois une exception pour Docker sous Windows qui permet de faire s’exécuter des conteneurs Windows via une implémentation native de runC 6.

Docker s’est vu adjoindre deux standards importants :

- Juin 2015, Open Container Initiative (OCI) : standardise les conteneurs entre les différents moteurs d’exécution existants en définissant des spécifications pour le runtime des conteneurs (Runtime spec) et les images (Image spec).

- Décembre 2016, Container Runtime Interface (CRI) : standardise la gestion des pods (ou stacks) de conteneurs dans le but d’utiliser une interface identique pour les différents moteurs d'exécution (permettant par exemple à Kubernetes d’utiliser Rkt ou Docker de manière identique).

Quelques concepts clés de Docker

- Container : un conteneur Docker est une unité logicielle légère et standardisée qui intègre une application et toutes ses dépendances afin de pouvoir les exécuter sur différents environnements logiciels. Un conteneur isole une application de son environnement et garanti qu’elle se comporte de manière identique sur tous les systèmes hôtes. Cela renforce la sécurité des applications.

- Docker Engine : c’est l’environnement d’exécution des conteneurs Docker. Le Docker Engine fournit aux conteneurs un environnement d’exécution aux propriétés identiques quel que soit le système hôte.

- Docker CLI : c’est l’outil en ligne de commande de Docker. Il propose de nombreuses commandes permettant d’interagir avec le moteur Docker : gérer les réseaux, construire des images, instancier des conteneurs, mettre à jour les services, gérer un cluster Docker Swarm…

- Hôte : machine virtuelle ou physique exécutant le Docker Engine.

- Image : une image Docker est un paquet de programmes exécutable, standalone et léger incluant tout ce qui est nécessaire pour faire fonctionner une application : code, environnement d'exécution, outils et bibliothèques système et configurations. Une image devient un conteneur lorsqu’elle est exécutée par le Docker Engine. Une image doit être construite (build) afin de pouvoir être utilisée.

- Layer : afin de gagner en place et en performance, les conteneurs et images Docker sont divisées en couche appelées layers. Ces couches sont stockées de manière indépendante, ce qui permet de les réutiliser entre plusieurs images. Chaque couche vient ajouter des fonctionnalités et des données à la précédente.

- Dockerfile : les étapes nécessaires à la configuration et à la construction d'une image Docker sont décrites dans un Dockerfile.

- Volume : un volume est un stockage de fichier permanent ou volatile monté dans un conteneur. Un volume peut-être partagé entre plusieurs conteneurs et peut correspondre ou non à un emplacement sur le système de fichier de la machine hôte. Les volumes Docker peuvent également être distants (par exemple en utilisant NFS).

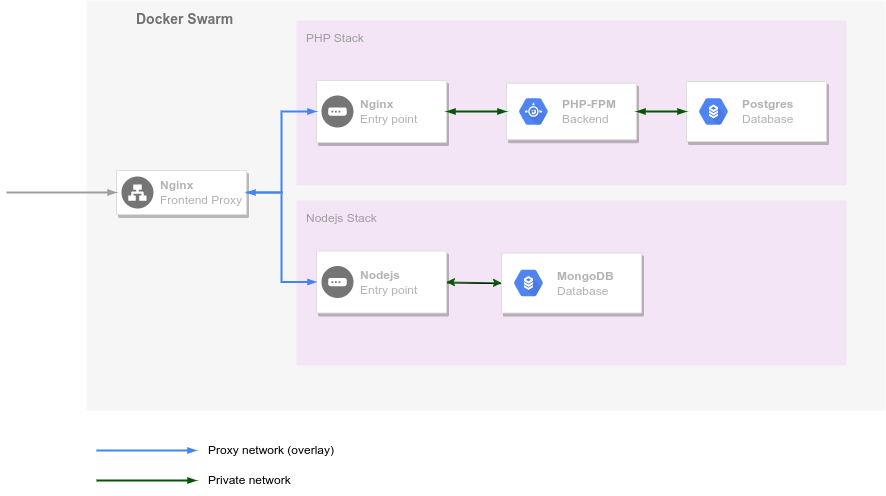

- Réseau : Docker permet de définir des interfaces réseaux virtuelles qui permettent aux conteneurs de communiquer entre eux au sein d’un hôte ou d’une stack ou avec l’extérieur. En particulier, les réseaux de type overlay permettent aux services d’une stack exécutés sur différents nœuds d’un cluster de communiquer entre eux.

- Stack : une stack (pile) est un ensemble de services (c’est-à-dire d'applications qui s'exécutent dans des conteneurs Docker) liés qui partagent une série de dépendances et peuvent être orchestrés (déployés et gérés) ensemble. Dans un Swarm Docker, une stack peut être répartie sur plusieurs hôtes Docker et certains services peuvent être répliqués afin de fournir une répartition de charge. Les stacks permettent la mise en place d’une architecture de type micro-services dans laquelle les composants nécessaires au fonctionnement d’une application (base de données, serveur web, environnement d’exécution PHP…) sont exécutés dans des conteneurs différents.

- Service : un service est un des sous-éléments d’une stack. Un service peut-être répliqué, c’est à dire être rendus par plusieurs containers identiques que l'on nommera des tasks (ou tâches) dans le vocabulaire Docker. Cette réplication permet d’assurer le failover et un load balancing. Lorsque les services sont atomiques (chaque service intégrant une seule fonctionnalité comme un service serveur web, un service base de données et un service environnement d'exécution PHP-FPM), on parle alors de micro-services.

- Orchestrateur : outil de déploiement et de gestion de conteneurs, Docker en propose deux :

- Docker Compose : orchestrateur permettant de définir et de déployer des applications multi-services (stack) localement sur une machine. Cet outil est construit au-dessus de l'API de Docker. Même s'il peut être utilisé en production, il est plutôt destiné au développement ou à des architectures pour lesquelles Docker Swarm ne peut être utilisé (IoT par exemple).

- Docker Swarm : orchestrateur permettant le déploiement de services sur un cluster de plusieurs machines hôtes appelées nœuds. Docker Swarm est adapté pour les besoins de production.

- Fichier docker-compose.yml : bien que Docker fournisse des commandes nécessaires pour déployer directement des services, ceux-ci peuvent également être définis dans un fichier de configuration

docker-compose.ymlqui reprend la définition de ses images, réseaux, volumes, options d’environnement… nécessaires au déploiement. Il devient alors possible de lancer tous les services en une seule commande avec Docker Compose. Ces fichiersdocker-compose.ymlsont également utilisés pour déployer les services sur un cluster Docker Swarm. - Nœud : hôte d’un cluster Docker Swarm. On distingue deux types de nœuds dans un cluster :

- les managers permettent la gestion du cluster (déploiement des services, états des ressources, création de volumes…),

- les workers exécutent les conteneurs des services.

- Registry et Hub : les images Docker une fois construites peuvent être publiées dans un Registry afin d’économiser du temps lors des déploiements. Le Hub est un Registry public regroupant des images pré-construites et téléchargeables par le Docker Engine.

- RAFT : algorithme utilisé entre les noeuds managers d’un Swarm afin d'arriver à un consensus. Cet algorithme contraint le nombre de nœuds managers nécessaires à garantir l'obtention du consensus en cas de crash de l’un d’entre eux.

Fichier Dockefile

Voici un exemple de fichier Dockerfile permettant de construire une image d'environnement d'exécution PHP :

FROM phpdockerio/php72-fpm:latest

WORKDIR /application

# Fix debconf warnings upon build

ARG DEBIAN_FRONTEND=noninteractive

# Install selected extensions and other stuff

RUN apt-get update \

&& apt-get -y --no-install-recommends install php-memcached php7.2-mysql php-redis php-xdebug php7.2-bcmath php7.2-gd php7.2-intl php7.2-soap php-yaml \

&& apt-get clean; rm -rf /var/lib/apt/lists/* /tmp/* /var/tmp/* /usr/share/doc/*

# Install git

RUN apt-get update \

&& apt-get -y install git \

&& apt-get clean; rm -rf /var/lib/apt/lists/* /tmp/* /var/tmp/* /usr/share/doc/*

Fichier Docker Compose

Voici un exemple de fichier docker-compose.yml définissant les services nécessaires à l'exécution d'une stack PHP simple composée de 3 services (memcached, webserver et php-fpm) :

version: "3.1"

services:

memcached:

image: memcached:alpine

webserver:

image: nginx:alpine

working_dir: /application

volumes:

- .:/application

- ./phpdocker/nginx/nginx.conf:/etc/nginx/conf.d/default.conf

ports:

- "8084:80"

php-fpm:

build: phpdocker/php-fpm

working_dir: /application

volumes:

- .:/application

- ./phpdocker/php-fpm/php-ini-overrides.ini:/etc/php/7.3/fpm/conf.d/99-overrides.ini

Cette stack peut être déployée localement avec docker-compose ou sur un cluster avec les commandes docker stack du mode swarm de Docker.

Docker et les pratiques Agile et DevOps

Docker, en particulier via des outils comme Docker Compose, est un outil facilitant la mise en place des approches DevOps et Agile de plusieurs manières.

En voici quelques-unes :

- Docker permet d’effectuer la gestion de l’infrastructure comme de la gestion de code. En effet, les fichiers de déploiement docker-compose.yml ou les Dockerfile peuvent être gérés et versionnés dans un outil de partage de code source tel que git. De plus, les opérations sur le Registry utilise un vocabulaire proche de celui des systèmes de gestion de code source (

push,pull,commit). - A travers la gestion des volumes et des fichiers de variables d’environnement, Docker facilite également la gestion des configurations comme du code.

- Docker permet de mettre en place l'intégration continue en facilitant l'automatisation des tests et de la validation par le déploiement d’environnements d’exécution. En poussant cette logique jusqu’au bout, l’infrastructure elle-même pourrait être testée et validée de manière automatique.

- En automatisant la création des environnements d’exécution, Docker permet la mise en place de la livraison et/ou du déploiement continu des applications.

- Les architectures en micro-services permettent également de limiter les risques lors de la mise en production d’une nouvelle version de l’application et limitant les changements sur l’infrastructure à ce qui a été effectivement modifié et en permettant un retour en arrière en cas de problème (via le système de Registry).

- Docker permet le mise à jour « à chaud » des conteneurs en cours d’exécution et facilite donc la mise à jour des piles applicatives.

Note : Ajoutons à cela que des solutions de CI/CD telles que Gitlab-CI s'intègre très simplement dans un environnement Docker et que Gitlab lui-même propose un repository d'images Docker intégré.

Quelles solutions pour un cluster avec Docker ?

Une solution simple pour déployer des stacks de services avec Docker est d’utiliser Docker Compose. Toutefois, même si elle permet de gérer la réplication des services, cette solution ne fonctionne que sur une seule machine hôte et ne permet donc pas d’assurer un fail-over en cas de crash de la machine hôte ou une répartition de charge sur plusieurs hôtes. Cette solution ne peut donc s’appliquer qu’à l’hébergement d’applications non critiques.

Au niveau des solutions permettant la mise en place d’un cluster d’hôte pour héberger des services basés sur le moteur Docker, la situation a beaucoup évolué ces derniers mois.

Jusqu’en 2020, l’écosystème des solutions à base de conteneurs proposait de nombreuses solutions de gestion et d’orchestration de cluster Docker :

- Docker Swarm : orchestrateur intégré à Docker et utilisant le même format de fichier de configuration de services que docker-compose

- Mesos : orchestrateur basé sur DC/OS de la Apache Foundation et plutôt destiné au calcul scientifique ou aux applications ayant un temps d’exécution de tâches assez long

- Kubernetes : orchestrateur supportant différents types de conteneurs maintenu par la Linux Foundation et sans doute la solution la plus utilisée à ce jour.

- Rancher : solution d’orchestration commerciale bâtie au-dessus d’une implémentation légère de Kubernetes (RKT) rachetée par SUSE

- Microk8s : solution d’orchestration légère et performante compatible avec Kubernetes, Microk8s est développé et maintenu par Canonical et optimisé pour des hôtes Ubuntu

Il existe également des solutions orientées vers la gestion complète d'une infrastructure de cloud telles que

- OpenShift : solution développée par RedHat et construite au-dessus de Kubernetes et de CoreOS.

- Ksphere : solution développée par D2iQ inc., basée sur Kubernetes et plutôt orientée vers le calcul scientifique.

- Mesosphere/Marathon : solution développée par D2iQ inc., basée sur Apache Mesos (ou Kubernetes) et plutôt orientée vers le calcul scientifique.

A cela s’ajoute des solutions liées à des clouds propriétaires :

- Amazon ECS pour le cloud Amazon EC2

- Azure Container Service pour le cloud Azure

- Google Container Engine pour le cloud Google

Toutefois, l’annonce de l’abandon de Dockershim (la couche permettant l'utilisation de Docker comme environnement d'exécution) dans Kubernetes fin 20207 a créé une certaine panique et a changé ce paysage. Depuis sa version 1.24 sortie en 2022, Kubernetes utilise directement containerd sans passer par Docker8.

Cette décision a donc créé deux écosystèmes différents, avec d'un côté les solutions compatibles avec Docker et de l'autre celles qui ont pris la même direction que Kubernetes. Il faudra sans doute encore attendre quelques mois voire quelques années pour voir quelles seront les conséquences de cette situation.

Solution choisie dans le cadre de ce projet

Le cœur de ce brevet est construit autour de la mise en place d’une infrastructure basée sur Docker Swarm.

Pourquoi ce choix ? Simplement par Docker Swarm est intégré à Docker qui était, au moment du démarrage de ce projet, le moteur de conteneur le plus populaire et ayant, de ce fait, la plus grande communauté et le plus de documentation disponible en ligne. De plus, Docker Swarm utilise des fichiers de déploiement de stack identiques à ceux de Docker Compose, lui-même utilisé pour de nombreuses applications. Cela permet d’écrire des fichiers de déploiement Docker Swarm pour de nombreuses applications et avec un minimum de travail d’adaptation.

Toutefois, je discuterai d’autres solutions dans la section consacrée aux perspectives plus loin dans le présent document.

Ajoutons à cela que l’infrastructure que je mets en place est destinée à des applications métier relativement modestes développées au sein des services informatiques.

Pour une infrastructure plutôt orientée vers l’hébergement d’applications web à destination d’un plus large public, une autre infrastructure, voire l’utilisation d’une solution plus complète comme OpenShift, pourrait être envisagée. Cette situation sort toutefois du propos de ce brevet, mais elle sera évoquée dans la section consacrée aux perspectives.

Docker Compose

Docker Compose est un orchestrateur pour Docker destiné à gérer des piles applicatives sur un seul noeud hôte.

Il peut être utilisé pour :

- déployer des services sur une infrastructure à un seul nœud

- développer et tester des applications déployées via Docker sur sa machine locale

- construire et tester des images Docker

Docker Compose fournit un format de déclaration de pile applicative commun avec Docker Swarm.

Docker Swarm

Swarm est un mode d’exécution intégré au Docker Engine pour l’orchestration d’un cluster.

Le mode swarm permet :

- la gestion d’un cluster

- la déclaration et le déploiement de services sur le cluster

- le scaling des applications sur le cluster

- la communication réseau entre les hôtes du cluster

- la répartition de charge entre les nœuds du cluster

- la mise à jour des services

Pourquoi choisir Docker Swarm ? Parce que Docker Swarm Rocks !.

Voici les raisons principales qui m'ont amené à choisir cette outil :

- Docker Swarm est intégré à Docker formant une suite complète : Docker comme moteur d'exécution de conteneurs, Docker Compose comme outil de développement et le mode Swarm pour déployer et gérer les applications en production

- Docker Swarm permet de créer un cluster d'une seule machine et de lui adjoindre des machines supplémentaires si nécessaire alors que la plupart des autres systèmes requièrent une machine d'orchestration séparée des autres nœuds du cluster

- Docker Swarm permet de mettre en place plusieurs nœuds manager

- Très simple à comprendre et à utiliser, le mode Swarm est entièrement basé sur le moteur Docker et ne requiert pas d'apprendre de nouveaux concepts

- Mettre en place un cluster prêt pour la production est très rapide environ 2h tout compris (c'est à dire y compris l'installation et la configuration des VM) pour un cluster de 5 machines; le mode swarm lui-même ne prend que 20 minutes pour sa mise en place !

Note : Le mode Swarm de Docker est basé sur le projet open source Swarmkit9.

Noeuds en mode swarm

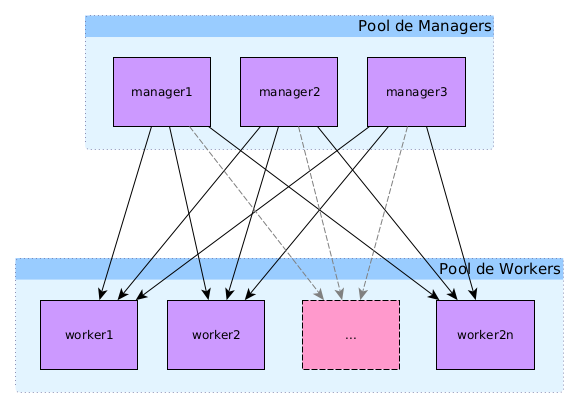

Dans un cluster en mode swarm, il existe deux types de nœuds10 : manager et worker.

Les nœuds de type manager en charge de maintenir l'état du cluster, planifier les services et servir de point d’entrée à l’API REST de docker. Les managers se basent sur l’algorithme de consensus distribué RAFT pour gérer l’état global du cluster

Les nœuds de type worker en charge d’exécuter les conteneurs et services à la demande des nœuds manager.

Note :

- Les commandes

docker node [COMMAND] [OPTIONS]permettent de gérer les nœuds du swarm.- Il est possible de changer le rôle d’un nœud avec les commandes

docker node promoteetdocker node demote.- Il est possible d’exclure un manager des nœuds disponibles pour le déploiement de service du swarm en mettant sa disponibilité à la valeur

Drainvia la commandedocker node update.

Un cluster Docker Swarm, ou plus simplement swarm, est constitué de plusieurs noeud pouvant exercer le rôle de manager ou de worker (ou les deux). Le rôle des managers est de maintenir l'état du swarm. Celui des workers est d'exécuter les tâches des différents services ou les containers "standalone".

Le swarm le plus simple est un swarm d'une seule machine qui tiendra à la fois le rôle de manager et de worker. A ce nœud, on peut ajouter des noeuds supplémentaires nœuds qui pourront également prendre le rôle de manager et/ou de worker.

Toutefois une telle infrastructure ne permet pas d'avoir de la redondance ou de la répartition de charge entre plusieurs machines, et ne convient donc pas à une infrastructure de production. Un swarm sera donc généralement constitué de plusieurs nœuds.

Dans une telle infrastructure à plusieurs nœuds, au moins un des nœuds devra tenir le rôle de manager (le nombre de manager doit obligatoirement être impair), les autres seront les workers.

Quelques remarques importantes concernant le mode swarm

Nœuds uniquement manager

Il est déconseillé (mais pas interdit) qu'un nœud joue à la fois le rôle de manager et de worker. Pour rendre un nœud "manager only" (c'est à dire qu'il ne pourra pas exécuter les tâches des services), il suffit d'exécuter la commande docker node update --availability drain <NODE>.

Remarque : Cette option ne sera pas implémentée dans les swarms présentés ici afin de permettre le déploiement de services sur les managers également (par exemple pour les applications portainer et swarmpit).

Redondance et consensus

Afin d'assurer une redondance des managers, il est possible d'ajouter d'autres manager au swarm. Toutefois,le nombre de manager doit être impérativement impair afin de garantir le consensus sur l'état du swarm lors de la perte d'un des managers.

En particulier, les managers vont élire un Leader parmi eux via le système de consensus RAFT11 12. Celui-ci sera la référence pour l'état du swarm. S'il devient indisponible, les autres managers éliront un nouveau Leader parmi eux.

Typiquement, le nombre de manager sera de 1, 3 ou 5. Au-delà de 5, les performances du swarm risquent de diminuer à cause de la communication nécessaire entre les managers et il est déconseillé de dépasser 7 managers pour un cluster.

Redondance et distribution des managers

Docker Swarm supporte la perte de (N - 1) / 2 managers, où N est le nombre de managers. Il est donc fortement conseillé que chaque manager se trouve isolé dans un data center différent des autres managers, ceci afin d'éviter que la perte d'un data center contenant plus de (N - 1) / 2 managers ne provoque la perte du consensus sur l'état du swarm. Comme on peut le voir dns le tableau ci-dessous, afin de garantir le fonctionnement optimal du cluster et supporter la perte d'un des managers, le nombre minimum de manager est de 3.

| Nombre de managers | Nombre de managers nécessaires pour garantir le quorum | Nombre de managers pouvant être perdus | Répartition (2 zones) | Répartition (avec 3 zones) |

|---|---|---|---|---|

| 1 | 1 | 0 | 1-0 | 1-0-0 |

| 2 | 2 | 0 | ||

| 3 | 2 | 1 | 2-1 | 1-1-1 |

| 4 | 3 | 1 | ||

| 5 | 3 | 2 | 3-2 | 2-2-1 |

| 6 | 4 | 2 | ||

| 7 | 4 | 3 | 4-3 | 3-2-2 |

| 8 | 4 | 3 | 4-4 | 3-3-2 |

| 9 | 5 | 4 | 5-4 | 3-3-3 |

Note :

- Avec 2 managers, le swarm peut parfaitement fonctionner tant qu'il ne faut pas (ré-)élire un leader entre ceux-ci.

- L'infrastructure fournie par SIPR n'a que 2 data centers et ne permet donc pas de résoudre ce problème actuellement. Une piste envisagée serait d'étendre le réseau des data centers jusque Woluwé afin de placer un manager là-bas. Une autre option, mais moins pratique, pourrait être de placer un des managers hors des data centers.

- Mon infrastructure de démonstration ne comprend qu'un seul manager. Il serait très simple de remédier à cette situation en convertissant les 2 workers en managers. Je ne l'ai pas fait à ce stade afin de pouvoir effectuer des tests de déploiement basés sur le rôle des noeuds dans le swarm, mais cela pourrait être fait une production. Une autre option serait simplement d'ajouter deux nouveaux noeuds managers au swarm.

Plus d'informations ainsi que les instructions pour un "disaster recovery" ou en cas de perte du quorum (par exemple lors de la perte de plus de (N-1) / 2 managers) peuvent être trouvées dans le guide d'administration de Docker Swarm : https://docs.docker.com/engine/swarm/admin_guide/

Les infrastructures du portail

L'infrastructure de formation du portail est un exemple de swarm constitué d'un seul nœud qui joue à la fois le rôle de manager et de worker.

L'infrastructure de développement du portail est un exemple d'un swarm avec 1 un seul manager et 2 workers.

Dans le cas des infrastructures de production et de QA du portail, le Swarm est constitué de 3 managers et d'un nombre variables de D*n workers où D est le nombre de data centers dans lequel les nœuds sont déployés et n le nombre de nœuds redondants. Pour les infrastructures du portail, à l'état initial, pour QA n = 1, pour la production n = 3 répartis entre les 2 data centers (D = 2 ). Ce qui nous donne respectivement un total de 5 noeuds (3 managers et 2 workers) pour la QA et 9 pour la production (3 managers et 6 workers).

Gérer les noeuds

Voici quelques commandes de gestion d'un Swarm Docker :

- Sortir un noeud worker (sur le worker à sortir) :

docker swarm leave - Rejoindre le swarm comme worker :

- sur le manager :

docker swarm join-token worker(copier la commande obtenue) - sur le worker :

docker swarm join --token <TOKEN> 10.1.4.63:2377(coller la commandede l'étape précédente)

- sur le manager :

- Lister les noeuds du swarm (sur le manager):

docker node ls - Supprimer un noeud fantôme (sur le manager) :

docker node rm <ID>

Services en mode swarm

Le déploiement d’application en mode swarm se fait en créant des services13. Pour cela, on peut utiliser soit la commande docker service create [OPTIONS], soit des fichiers de configuration de services docker-compose.

Chaque service est l’image d’un microservice d’une application. Il peut s’agir, par exemple, d’un serveur web nginx, d’un environnement d’exécution php ou d’une base de données.

Chaque service nécessite la définition d’une image Docker et de la commande à exécuter dans cette image. On peut aussi spécifier pour chaque service les ports exposés, le réseau à utiliser pour communiquer avec d’autres services du Swarm, des ressources CPU ou mémoire allouées, le nombre de répliques (replicas dans le vocabulaire de Docker)…

Pour chaque service, le manager va planifier (schedule) une tâche par réplique du service, chaque tâche exécutant un conteneur.

Chaque nœud manager est composé

- d'un orchestrateur qui crée les tâches

- d'un allocateur d’adresse IP

- d'un dispatcheur qui assigne les tâches aux différents nœuds

- d'un planificateur (scheduler) qui lance l’exécution des tâches

Chaque nœud worker comprend le worker proprement dit qui va chercher les tâches qui lui sont assignées auprès du dispatcheur et d’un exécuteur qui exécute les tâches proprement dites.

Les services peuvent être répliqués sur 1 ou plusieurs nœuds, c’est-à-dire qu’il exécutera une tâche sur chacun de ces nœuds. Un service global sera répliqué sur tous les nœuds du swarm.

Déploiement et gestion d’un cluster en mode swarm

La mise en place d’un cluster en mode swarm est assez simple14 :

- Déployer les hôtes du cluster (des machines Linux)

- Installer Docker sur les hôtes

- Ouvrir les ports nécessaires à Docker

- Initialiser le cluster sur le nœud manager

docker swarm init [OPTIONS] - Exécuter la commande pour rejoindre le cluster sur les nœuds workers

docker swarm join [OPTIONS]

Une fois ces opérations effectuées, il est alors possible de gérer les services sur le cluster a l'aide des commandes docker service [COMMAND] [OPTIONS] ou de gérer les stacks avec les commandes docker stack [COMMAND] [OPTIONS].

Les étapes du déploiement seront décrites en détail dans la section suivante « Infrastructure de démonstration basée sur Docker Swarm »

Mise à jour des services à chaud

Les services d’une stack peuvent être facilement mis à jour à chaud, par exemple lors d’un changement dans les fichiers de configuration du service.

Prenons comme exemple la modification de la configuration de nginx dans une stack constituée de 3 services : mariadb, php-fpm et nginx.

La première étape consiste à obtenir l’id du service à mettre à jour via la commande docker stack services STACK_NAME :

~$ docker stack services fminne73

ID NAME MODE REPLICAS IMAGE PORTS

cn1jy6ixuy09 fminne73_database replicated 1/1 mariadb/server:latest

iwsqg4zp3i4m fminne73_php-fpm replicated 1/1 dkm-webapps.sipr-dc.ucl.ac.be:5000/drupal_phpfpm73:latest

tb1pfcxly9ea fminne73_webserver replicated 1/1 dkm-webapps.sipr-dc.ucl.ac.be:5000/drupal_webserver:latest

La mise à jour s’effectue alors à l’aide de la commande docker service update [OPTIONS] SERVICE_ID :

~$ docker service update --force tb1pfcxly9ea

tb1pfcxly9ea

overall progress: 1 out of 1 tasks

1/1: running [==================================================>]

verify: Service converged

L’option --force est employée pour forcer le rechargement du service.

Il est également possible de mettre à jour l'image utilisée par un service via la commande docker service update --image SERVICE_ID.

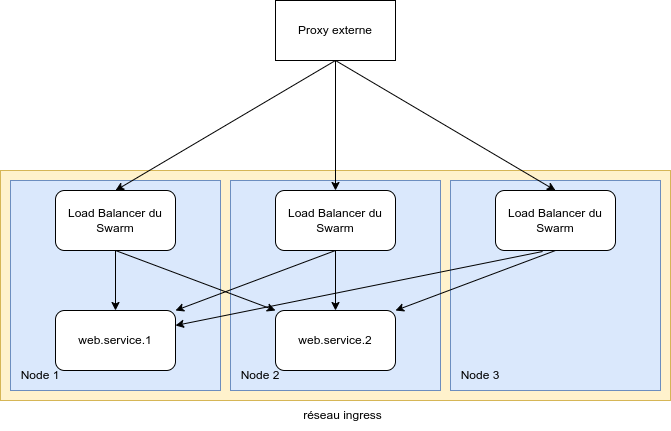

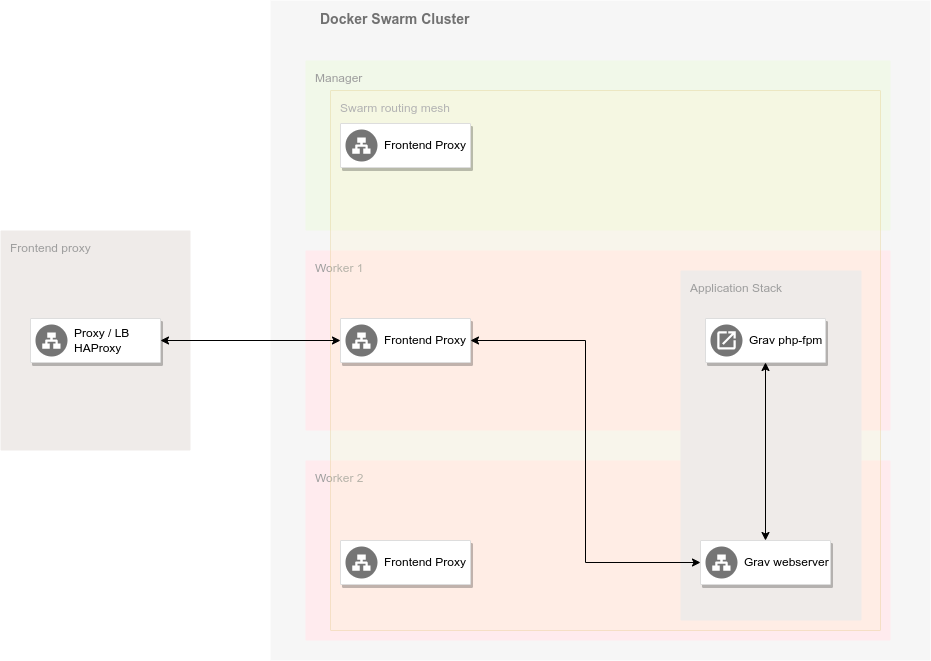

Swarm Routing Mesh et résolution de noms

Docker intègre son propre mécanisme de routing pour joindre les conteneurs quel que soit le noeud sur lequel ils sont déployés. Ce mécanisme appelé Routing Mesh15 est mis en place à travers la définition d'un réseau spécifique, le réseau Ingress.

Toute requête adressée sur un port d'un noeud du Swarm sera résolue via ce mécanisme qui intègre un mécanisme de répartition de charge. Il n'est donc pas garanti que le conteneur qui va traiter la requête se trouve sur le noeud qui a reçu la requête.

En plus de ce mécanisme, Docker intègre un système de resolution de nom qui permet joindre n'importe quel service sur base du nom qui lui a été donné lors de son déploiement. Toute requête à ce service passera également par le mécanisme de répartition de charge intégré à Docker Swarm.

Wikipedia OS-level virtualization https://en.wikipedia.org/wiki/OS-level_virtualization

« Difference between Docker and Vagrant » https://www.quora.com/What-is-the-difference-between-Docker-and-Vagrant-When-should-you-use-each-one

Il existe 2 types d’hyperviseur le type 1 (Xen, KVM) s'exécute directement sur une machine physique (hardware), le type 2 (QEMU, VirtualBox, VMware) s'exécute sur un système d’exploitation hôte.

Par opposition à une infrastructure monolithique dans laquelle tous les services d’une application (serveur web, base de données, environnement d’exécution…) sont déployés sur un seul système, les architectures micro-services isolent chaque service dans un conteneur séparé et indépendant, facilitant ainsi leur maintenance (mise à jour, replacement…)

Au départ Docker se basait sur LXC avant de passer à sa propre implémentation : runC.

runc is a CLI tool for spawning and running containers according to the OCI specification https://github.com/opencontainers/runc

Kubernetes Blog « Don't Panic: Kubernetes and Docker » https://kubernetes.io/blog/2020/12/02/dont-panic-kubernetes-and-docker/

« Kubernetes is Moving on From Dockershim: Commitments and Next Steps » https://kubernetes.io/blog/2022/01/07/kubernetes-is-moving-on-from-dockershim/

« Swarmkit, a toolkit for orchestrating distributed systems at any scale » https://github.com/docker/swarmkit/

« How nodes work » https://docs.docker.com/engine/swarm/how-swarm-mode-works/nodes/

« Pour une explication détaillée du consensus Raft » http://thesecretlivesofdata.com/raft/ et https://raft.github.io/

« Raft consensus in swarm mode » https://docs.docker.com/engine/swarm/raft/

« How services work » https://docs.docker.com/engine/swarm/how-swarm-mode-works/services/

« Getting started with swarm mode » https://docs.docker.com/engine/swarm/swarm-tutorial/

Use swarm mode routing mesh https://docs.docker.com/engine/swarm/ingress/

Mise en place d'une infrastructure de démonstration

- Introduction

- Infrastructure à déployer

- Setup inital

- Installation et configuration de Docker

- Déploiement du cluster Docker Swarm

- Système de fichier

- Reverse proxy en entrée du cluster

Introduction

La mise en place de mon infrastructure de démonstration s'est réalisée en plusieurs phases :

- 2018-2019 : mise en place d’une première infrastructure de démonstration et de développement pour le portail UCLouvain

- janvier 2022 : passage en production de l’infrastructure Docker Elastic Search des bibliothèques basée sur cette première infrastructure de démonstration

- avril 2022 : mise en place d’une nouvelle infrastructure de démonstration afin de tenir compte des évolutions de Docker depuis 2019

- juin 2022 : dérivation de l’infrastructure dckr.sisg pour les besoins de production du nouveau portail UCLouvain

L’objectif était d’expérimenter les possibilités de Docker et d’étudier son adéquation avec les besoins des futures infrastructures web, en profitant des opportunités offertes par le développement du nouveau portail UCLouvain.

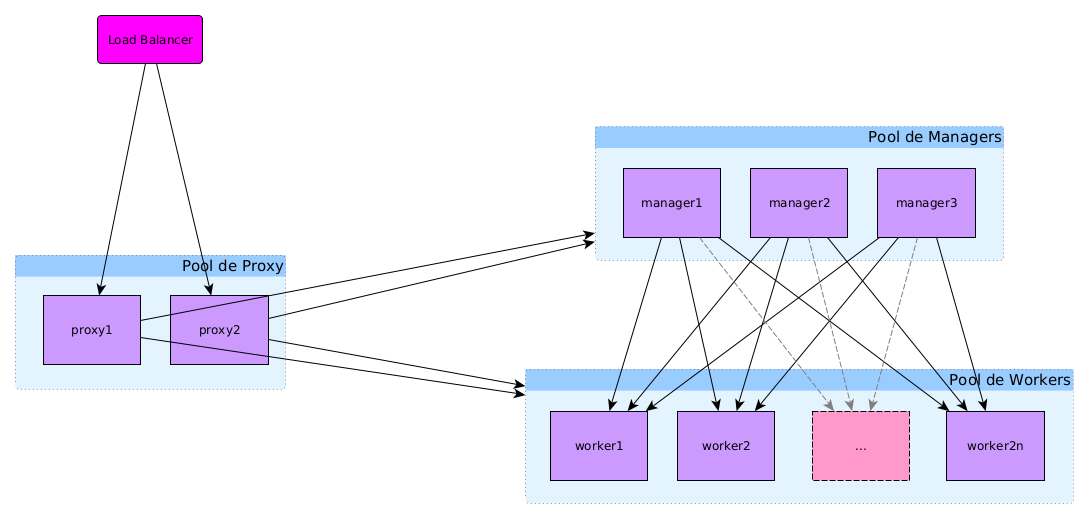

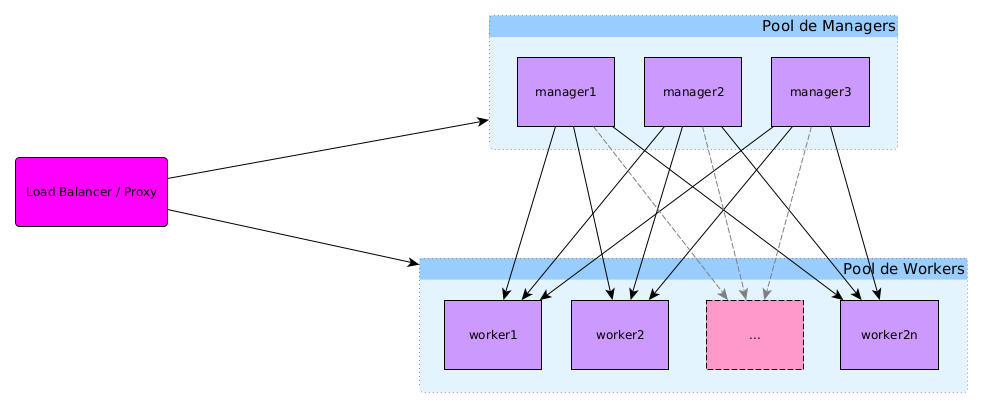

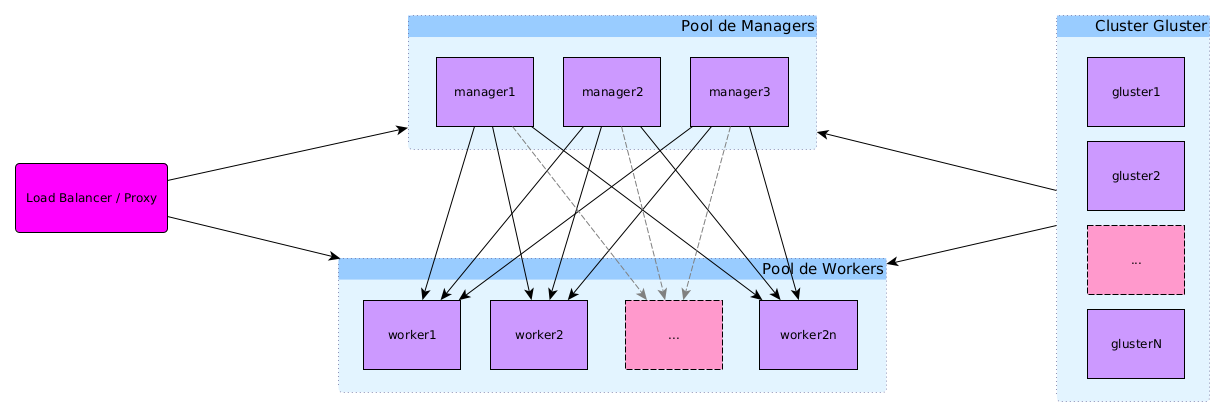

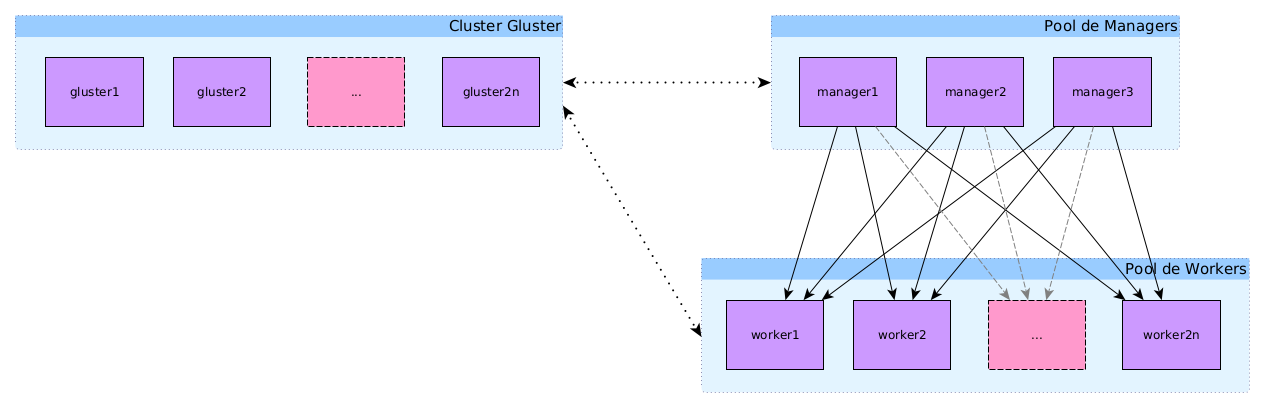

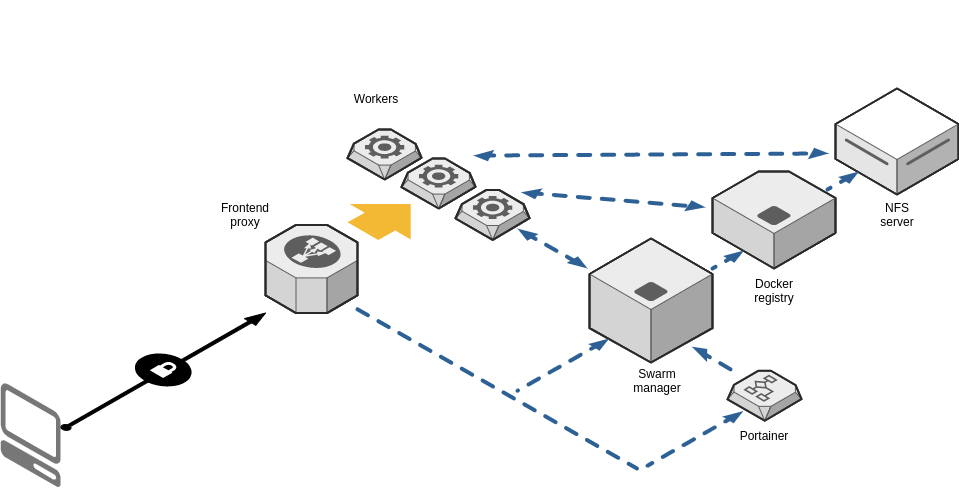

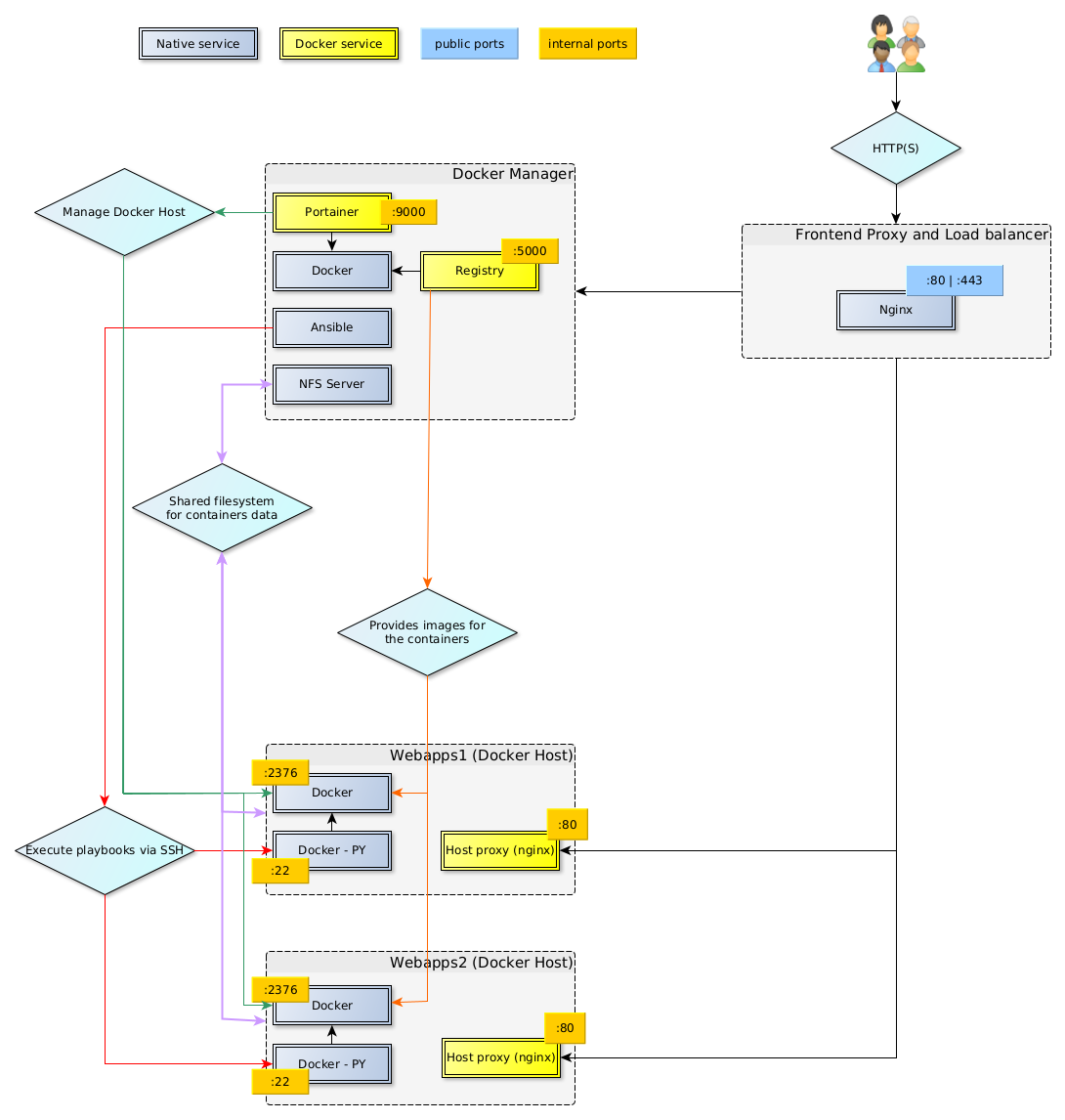

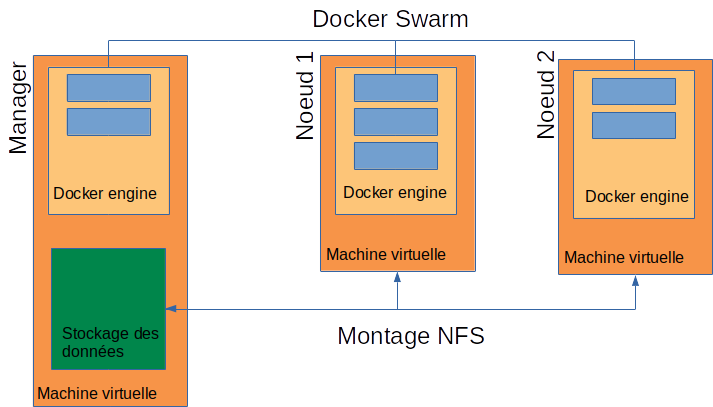

Infrastructure à déployer

L’infrastructure à déployer mettra à disposition un swarm Docker pour héberger des applications web.

Éléments constitutifs de l'infrastructure :

- Pool de managers : machines qui assurent la gestion du swarm et servent les applications de gestion, de monitoring…

- Pool de workers : machines qui servent les applications exécutées sur le swarm

À cela s'ajoute le load balancer/Proxy (géré par SIPR) qui permet la répartition de charge entre les machines du swarm, redirige les requêtes sur les bonnes machines en fonction du fqdn et assure également la liaison sécurisée https avec les machines clientes

Dimensionnement des machines virtuelles et points de montage

Il y a 3 machines virtuelles pour mon infrastructure.

Voici leur spécification technique.

Manager (1 machine)

- 4 coeurs

- RAM 16G

- Disques :

- / 20G

- /home 20G

- /dockerdata-ceph 40G

- /var/lib/docker 40G

- /var/lib/docker.bk 10G

- OS : Debian 11

- Doit pouvoir faire des requêtes vers l'extérieur sur les ports

- 80, 443 (git vers github)

- 22 (git via ssh sur gitlab.sisg.ucl.ac.be et forge.uclouvain.be)

- 11371 (key server)

Notes :

- Le point de montage

/dockerdata-cephest destiné à contenir les fichiers partagés entre les services déployés sur l'infrastructure et qui seront montés en tant que volumes. Ces données devront être disponibles sur tous les noeuds du cluster et seront dès lors exportées depuis le manager via NFS.- Le point de montage

/var/lib/dockerest destiné au stockage des données propres à Docker- L'usage a montré que le répertoire

/var/lib/docker.bkpouvait grandir rapidement et consommer de l'espace sur le système de fichier racine de la machine. J'ai donc décidé de l'externaliser via un point de montage séparé.- Le choix de Debian 11 était le choix fait à l'origine, mais il n'est en rien obligatoire. Les étapes décrites dans ce chapitre fonctionnent sur n'importe qu'elle distribution basée sur Debian (par exemple Ubuntu) et, avec un peu d'adaptation, sur n'importe quelle distribution Linux. Pour des infrastructures plus récentes, j'ai tendance à lui préférer Ubuntu dans sa dernière version LTS (la 22.04 au moment d'écrire ce texte) qui offre une plus grande stabilité et des paquets plus régulièrement mis à jour que Debian.

Workers (2 machines)

- 4 coeurs

- RAM 16G

- Disques :

- / 20G

- /home 20G

- /var/lib/docker 40G

- /var/lib/docker.bk 10G

- OS : Debian 11

- Doivent pouvoir faire des requêtes vers l'extérieur sur les ports

- 80, 443

Setup inital

Voici les étapes préliminaires nécessaires avant de pouvoir installer Docker sur les machines virtuelles.

Génération de la locale fr_BE.UTF-8

Sur les machines Debian 11 fournies par SIPR, la locale par défaut fr_BE.UTF-8 n'est pas générée. Cela provoque l'affichage d'avertissements lors de l'exécution de nombreuses commandes.

Pour y remédier, il suffit de générer cette locale :

sudo dpkg-reconfigure locales

# Sélectionner fr_BE.UTF-8 dans la liste (avec flèches pour naviguer puis espace pour sélectionner)

# Sélectionner fr_BE.UTF-8 comme locale par défaut (avec flèches pour naviguer puis espace pour sélectionner)

# Choisir OK pour générer les locales

Note : l'idéal serait que la locale

fr_BE.UTF-8soit intégrée dans les templates des images Debian de SIPR.

Configuration du proxy (optionnel)

Si les machines ne sont pas sur le bon gateway, ou si elles ne sont pas encore autorisées à sortir sur les ports nécessaires sur le load balancer HAProxy de SIPR, il peut être nécessaire de configurer le passage par le proxy HTTP(S) des Data Center afin d'accéder à l'Internet et pouvoir installer les paquets requis. Ce proxy doit être configuré pour différentes applications.

Note : Attention toutefois que pour l'utilisation de Docker, les machines devront être capables de faire des requêtes vers l'extérieur sur les ports 22 et 11371 qui ne sont pas pris en charge par le proxy du Data Center. Configurer le proxy HTTP(S) permet toutefois l'installation des paquets nécessaires sur les machines en attendant que la configuration sur le load balancer HAProxy de SIPR soit terminée.

Apt (normalement pas nécessaire)

Normalement le proxy est déjà configuré pour le gestionnaire de paquets apt dans les images Debian 11 de SIPR.

Pour le vérifier :

cat /etc/apt/apt.conf.d/01proxy

# Doit contenir les lignes suivantes :

# Acquire::http::Proxy "http://proxy.sipr.ucl.ac.be:889/";

# Acquire::https::Proxy "http://proxy.sipr.ucl.ac.be:889/";

Si ce n'est pas le cas, il suffit de créer le fichier /etc/apt/apt.conf.d/01proxy :

# vim /etc/apt/apt.conf.d/01proxy

Acquire::http::Proxy "http://proxy.sipr.ucl.ac.be:889/";

Acquire::https::Proxy "http://proxy.sipr.ucl.ac.be:889/";

Wget

Contrairement à curl qui utilise les variables d’environnement pour le proxy, wget utilise sa propre configuration. Il faut ajouter le proxy au fichier /etc/wgetrc.

Les wildcards n'étant pas supportées par la configuratuion, il est nécessaire de scripter l'ajout des IP de machine du sous-réseau de mon infrastructure echo 10.1.4.{1..255},.

# vim /etc/wgetrc

https_proxy = http://proxy.sipr.ucl.ac.be:889/

http_proxy = http://proxy.sipr.ucl.ac.be:889/

no_proxy = `echo 10.1.4.{1..255},`localhost,127.0.0.1,.sipr-dc.ucl.ac.be

Bash

Les wildcards n'étant pas supportées par Bash, il est nécessaire de scripter l'ajout des IP de machine du sous-réseau de mon infrastructure echo 10.1.4.{1..255},.

vim ~/.bashrc

# ajouter les lignes suivantes à la fin du fichier :

export http_proxy='proxy.sipr.ucl.ac.be:889'

export https_proxy='proxy.sipr.ucl.ac.be:889'

export no_proxy=`echo 10.1.4.{1..255},`localhost,127.0.0.1,.sipr-dc.ucl.ac.be

# recharger le fichier .bashrc

. ~/.bashrc

Installation des paquets de base

Installation des paquets requis pour la suite des opérations.

# Mise à jour de la liste des paquets

sudo apt update

# Mise à jour de paquets déjà installés

sudo apt upgrade

# Installation des nouveaux paquets

sudo apt install \

ca-certificates \

gnupg \

lsb-release \

vim \

htop \

ansible \

git

Configuration du proxy pour git

Il reste encore à configurer git pour utiliser le proxy

# Soit de manière globale

git config --global http.proxy http://proxy.sipr.ucl.ac.be:889

# Soit pour le projet courant uniquement

git config http.proxy http://proxy.sipr.ucl.ac.be:889

Ajouts des groupes "admin"

Par facilité, on peut ajouter l'utilisateur courant, ainsi que les autres utilisateurs amenés à gérer la machine, aux groupes adm et staff afin d'éviter de devoir utiliser sudo pour certaines actions. Le groupe adm donne accès aux logs, le groupe staff permet de modifier le contenu du répertoire /usr/local

# Accès aux logs

sudo usermod -aG adm $USER

# Accès à /usr/local

sudo usermod -aG staff $USER

Il faudra se déconnecter et se reconnecter à la session pour que cela soit actif ou utiliser la commande newgrp.

Installation et configuration de Docker

Cette section constitue un mode d’emploi pour la mise en place d’une infrastructure Docker, Certaines opérations sont à réaliser sur tous les types de noeuds du cluster alors que certaines sont spécifiques aux noeuds managers ou workers.

Installation de l'environnement Docker (tous les nœuds)

La procédure d'installation des paquets de Docker est simplement celle décrite sur le site officiel :

# Suppression des versions précédentes de Docker

sudo apt remove docker docker-engine docker.io containerd runc

# Obtention de la clé GPG du dépôt des paquets de Docker

sudo mkdir -p /etc/apt/keyrings

curl -fsSL https://download.docker.com/linux/debian/gpg | sudo gpg --dearmor -o /etc/apt/keyrings/docker.gpg

# Ajout du dépôt

echo \

"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://download.docker.com/linux/debian \

$(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

# Mise à jour de la liste des paquets

sudo apt update

# Installation des paquets Docker

sudo apt install docker-ce docker-ce-cli containerd.io docker-compose-plugin

Configuration de Docker (tous les nœuds)

Une fois Docker installé, il reste à le configurer correctement.

Créer un fichier pour systemctl

Par défaut, Docker se lance avec une série d'options que je veux modifier dans mon infrastructure. De plus j'aimerais fournir une partie de ces options via le fichier /etc/docker/daemon.json. Or certaines de ces options risques d'entrer en conflit avec les options par défaut de Docker et le daemon refusera de se lancer.

Pour contourner ce problème, il suffit de modifier les options par défaut passées au service Docker par systemd.

Cela se fait relativement simplement en créant un fichier d'override de configuration pour le service docker.service dans lequel je vais retirer toutes les options passées au daemon Docker (puisqu'elles seront définies dans mon fichier daemon.json). Cela peut se faire soit à la main, soit en utilisant systemctl, l'outil de gestion de systemd.

À la main

sudo mkdir -p /etc/systemd/system/docker.service.d

Ajouter le fichier docker.conf :

# vim /etc/systemd/system/docker.service.d/docker.conf

[Service]

ExecStart=

ExecStart=/usr/bin/dockerd

Avec systemctl

sudo systemctl edit docker.service

Ajouter le code suivant dans la zone prévue en début de fichier :

[Service]

ExecStart=

ExecStart=/usr/bin/dockerd

Configurer Docker via daemon.json

Configuration de base dans daemon.json, sudo vim /etc/docker/daemon.json :

{

"storage-driver": "overlay2",

"log-driver": "local",

"debug": false

}

Note : Les options du driver local pour les logs sont décrites dans la documentation de Docker

Activer l'accès à l'API du daemon Docker via tcp

Deux ports sont possibles : 2375 (HTTP uniquement) ou 2376 (HTTP avec ou sans TLS).

Dans /etc/docker/daemon.json ajouter la configuration des sockets pour dockerd :

{

/* ... */

hosts: ["unix:///var/run/docker.sock", "tcp://0.0.0.0:2376"]

}

Notes :

- L'utilisation de

tcp://0.0.0.0:2376n'est en théorie pas sécurisée car elle permet à n'importe quelle machine de parler au daemon Docker. Néanmoins, dans le cadre de mon infrastructure, cela ne pose pas de problème, puisqu’il est facile de limiter les accès aux machines du cluster elles-mêmes via des règles de firewall. j’ajouterais également, que le port 2376 n'étant accessible que via le VLAN des noeuds Docker, les risques sont assez réduits surtout en comparaison de la simplification qu'ils permettent dans la gestion du cluster.- Je n'ai pas activé le TLS sur le port 2376 à ce stade et ce principalement pour 2 raisons : il n'est pas nécessaire pour les raisons citées plus haut (VLAN + firewall), il requiert un certificat pour lequel il me semble préférable d'attendre qu'une CA "interne" aux Data Center SIPR soit disponible (l'alternative étant un certificat auto-signé).

Configurer un registry non sécurisé

Par défaut, Docker refuse d'utiliser un registry qui ne serait pas accessible via HTTPS. Il est toutefois possible de définir des regitries non sécurisés directement dans la configuration du daemon.

Dans /etc/docker/daemon.json ajouter la configuration du registry (l'installation du registry est décrite plus loin) :

{

/* ... */

"insecure-registries" : [ "private-registry:5000" ]

}

Configurer les métriques pour le monitoring

Dans /etc/docker/daemon.json ajouter la configuration pour l'accès aux métriques via une API REST. Cet accès sera nécessaire pour la mise en place du monitoring :

{

/* ... */

"metrics-addr" : "127.0.0.1:9323",

"experimental" : true,

/* ... */

}

Note : la question du monitoring sera abordée dans le chapitre Perspectives

Mon fichier daemon.json complet

Voici le fichier daemon.json complet :

{

"storage-driver": "overlay2",

"log-driver": "local",

"debug": false,

"metrics-addr" : "127.0.0.1:9323",

"experimental" : true,

"insecure-registries" : [ "private-registry:5000" ],

"hosts": ["unix:///var/run/docker.sock", "tcp://0.0.0.0:2376"]

}

Relancer le daemon Docker

Recharger la configuration de systemd sudo systemctl daemon-reload et relancer docker sudo systemctl restart docker.

Puis relancer Docker : sudo systemctl restart docker

Configurer le proxy (optionnel)

Note : ces étapes ne sont nécessaires que si les machines n'ont pas un accès direct vers l'extérieur sur les ports 80 et 443. Cela ne suffira toutefois pas pour pouvoir construire certaines images Docker qui nécessite soit un accès aux serveurs de clés publiques via le port 11371 ou un accès à git via ssh (port 22).

Options de Docker

sudo vim /etc/default/docker:# Docker Upstart and SysVinit configuration file # # THIS FILE DOES NOT APPLY TO SYSTEMD # # Please see the documentation for "systemd drop-ins": # https://docs.docker.com/engine/admin/systemd/ # # Customize location of Docker binary (especially for development testing). #DOCKERD="/usr/local/bin/dockerd" # Use DOCKER_OPTS to modify the daemon startup options. #DOCKER_OPTS="--dns 8.8.8.8 --dns 8.8.4.4" DOCKER_OPTS="--config-file=/etc/docker/daemon.json" # If you need Docker to use an HTTP proxy, it can also be specified here. export http_proxy="http://proxy.sipr.ucl.ac.be:889 export https_proxy="http://proxy.sipr.ucl.ac.be:889 export no_proxy=`echo 10.1.4.{1..255},`,localhost,127.0.0.1,.sipr-dc.ucl.ac.be # This is also a handy place to tweak where Docker's temporary files go. #export DOCKER_TMPDIR="/mnt/bigdrive/docker-tmp"Créer le répertoire de configuration de Docker pour systemd

sudo mkdir /etc/systemd/system/docker.service.dCréer le fichier de configuration du proxy

/etc/systemd/system/docker.service.d/http_proxy.conf[Service] # NO_PROXY is optional and can be removed if not needed Environment="HTTP_PROXY=http://proxy.sipr.ucl.ac.be:889" "HTTPS_PROXY=http://proxy.sipr.ucl.ac.be:889" "NO_PROXY=localhost,127.0.0.0/8,10.1.4.1/24,*.sipr-dc.ucl.ac.be"Recharger les configurations de systemd via

sudo systemctl daemon-reloadVérifier que les options sont bien prises en compte

sudo systemctl show docker --property EnvironmentRedémarrer docker :

sudo systemctl restart docker

Ajout de l'utilisateur courant au groupe Docker (tous les nœuds)

Par facilité, on ajoute l'utilisateur courant au groupe docker afin d'éviter d'avoir à utiliser sudo pour exécuter les commandes Docker :

# Ajout de l'utilisateur au groupe docker

sudo usermod -aG docker $USER

Pour appliquer ce changement, il reste alors à recharger la session, soit en quittant et en se reconnectant, soit via la commande newgrp :

# Rechargement de la session pour tenir compte du changement

newgrp docker

Note :

newgrplance une nouvelle session du shell au sein de la session actuelle. Il faudra donc utiliser la commandeexitdeux fois pour quitter la session.

Installation de Docker Compose (managers uniquement)

L'outil Docker Compose nous permettra d'effectuer le build des images Docker sur le manager. Il permettra également de déployer des stacks localement sur les managers si nécessaire.

curl -L "https://github.com/docker/compose/releases/download/v2.5.0/docker-compose-$(uname -s)-$(uname -m)" -o ./docker-compose

# Installer docker-compose

sudo chmod +x docker-compose

sudo mv docker-compose /usr/local/bin/.

# Commande alternative pour

sudo install -o root -g root -m 0755 docker-compose /usr/local/bin/docker-compose

# Vérifier que l'installation s'est bien passée

docker-compose -v

Si l'utilisateur est déjà dans le groupe staff, il suffit d'exécuter

curl -L "https://github.com/docker/compose/releases/download/v2.5.0/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

docker-compose -v

Architectures possibles :

- Un swarm de N noeuds tenant à la fois le rôle d'hôte docker et de noeud glusterfs (c'est à dire /data/.../vol-1 et /mnt/vol-1 sur chacun des noeuds)

- Un swarm de N noeuds couplé à un cluster gluster de M noeuds

Script pour automatiser l'installation et l'update

#!/bin/bash

# Get latest docker compose released tag

COMPOSE_VERSION=$(curl -s https://api.github.com/repos/docker/compose/releases/latest | grep 'tag_name' | cut -d\" -f4)

# Continue ?

echo "Will install docker-compose versin ${COMPOSE_VERSION}"

read -n 1 -s -r -p "Press any key to continue [ctrl-c to abort]"

# Get docker-compose binary

curl -L "https://github.com/docker/compose/releases/download/${COMPOSE_VERSION}/docker-compose-$(uname -s)-$(uname -m)" -o ./docker-compose.${COMPOSE_VERSION}

# Install docker-compose

sudo install -o root -g root -m 0755 docker-compose.${COMPOSE_VERSION} /usr/local/bin/docker-compose

# Cleanup

rm docker-compose.${COMPOSE_VERSION}

# Output compose version

docker-compose -v

exit 0

Installation en tant que plugin Docker

Dans les versions récentes de Docker, Docker Compose est disponible sous la forme d'un plugin pour l'outil en ligne de commande :

sudo apt install docker-compose-plugin

Son utilisation est identique à celle de Docker Compose en version standalone, seule la manière d'appeler la commende change : de docker-compose <command> <option> elle devient docker compose <command> <option>.

Note : L'installation standalone permet d'avoir une version plus à jour de Docker Compose

docker compose version: Docker Compose version v2.17.3docker-compose version: Docker Compose version v2.18.1

De plus la version du plugin est maintenue par les mainteneurs des paquets Docker pour les différentes distributions Linux.

Déploiement du cluster Docker Swarm

Le déploiement du swarm se fait en plusieurs étapes :

- activation du swarm et création du premier manager

- (optionnel) ajout de managers supplémentaires

- ajout des workers

- (optionnel) promotion de workers en managers

L'exemple suivant est basé sur une infrastructure avec 5 noeuds afin de donner une vue plus complète de l'initialisation d'un Swarm Docker. Dans le cas de mon infrastructure de démonstration, je suis directement passé à l'ajout des workers après l'initialisation du Swarm et la création du premier manager.

Activation du swarm et création du premier manager

Pour activer le swarm et créer le premier manager, il suffit d'exécuter la commande suivante :

# Initialisation du swarm

docker swarm init --advertise-addr <IP_DU_MANAGER>

# affiche un résultat du type

# docker swarm join --token <UN_LONG_TOKEN> <IP_DU_MANAGER>:2377

Notes : Le token généré lors de cette commande sera nécessaire pour joindre les autres nœuds au swarm.

La commande docker swarm join-token worker permet d'afficher ce token par la suite.

Après cette opération, on obtient un swarm composé d'un seul nœud qui remplira à la fois le rôle de manager et de worker.

La commande docker nod ls permet de visualiser les neuds du swarm :

# Vérifier l'état du cluster

docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

kuj58tn3l1ueyuyt4nnjtulip * manager1 Ready Active Leader 20.10.13

Pour un swarm à un seul nœud , comme l'infrastructure de formation du portail, c'est tout ! Le swarm est prêt à être utilisé. Pour un swarm à plusieurs nœuds, il faut maintenant joindre les autres nœuds au cluster.

Ajout des autres noeuds

Une fois le swarm initialisé, il est possible de lui ajouter d'autres nœuds workers ou managers.

Ajout des autres managers

Dans un swarm avec plusieurs managers, il reste à promouvoir les autres managers.

Pour obtenir un consensus sur l'état du cluster, il faut un nombre impair de managers. Afin de combiner redondance et performances, 2 managers supplémentaires sont ajoutés. Ajouter des managers supplémentaires peut se faire de deux manières :

- En spécifiant le rôle de manager dans la commande en exécutant la commande générée par

docker swarm join-token managersur chacun des managers supplémentaires (voir plus haut) - En promouvant les noeuds en manager depuis le premier manager. Cette méthode est décrite plus bas.

Comme ici on sait déjà quels nœuds seront les managers, ils sont ajoutés au swarm directement avec ce rôle en exécutant la commande affichée par docker swarm join-token manager sur chacun d'entre eux :

# Afficher la commande à exécuter sur les workers

docker swarm join-token manager

# Retourne une commande du type à exécuter sur chacun des noeuds manager supplémentaires

docker swarm join --token <UN_LONG_TOKEN> <IP_DU_MANAGER>:2377

On peut alors vérifier l'état du cluster et que les 3 managers sont bien disponibles

# Vérifier l'état du cluster

docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

kuj58tn3l1ueyuyt4nnjtulip * manager1 Ready Active Leader 20.10.13

0whu7cq053xvrnrrtylrqp52e manager2 Ready Active Reachable 20.10.13

k6h1kd3pd8l5ja9o29jhqmnmf manager3 Ready Active Reachable 20.10.13

Si on ne sait pas encore quels nœuds seront manager ou si on veut donner le rôle de manager à des workers, il est possible de promouvoir un worker. La procédure est décrite plus loin.

Ajout des workers

Il suffit joindre les autres nœuds au swarm en exécutant la commande affichée par docker swarm join-token worker sur chacun d'entre eux :

# Afficher la commande à exécuter sur les workers

docker swarm join-token worker

# Retourne une commande du type à exécuter sur chacun des noeuds worker

docker swarm join --token <UN_LONG_TOKEN> <IP_DU_MANAGER>:2377

On peut vérifier que les noeuds sont bien ajoutés en exécutant la commande docker node ls sur le manager (ici on a ajouté 4 noeuds)

# Vérifier l'état du cluster

docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

kuj58tn3l1ueyuyt4nnjtulip * manager1 Ready Active Leader 20.10.13

0whu7cq053xvrnrrtylrqp52e manager2 Ready Active Reachable 20.10.13

k6h1kd3pd8l5ja9o29jhqmnmf manager3 Ready Active Reachable 20.10.13

opnn5kj1839pq603m1fbh029i worker1 Ready Active 20.10.13

zqnzuwfmk2argo5eobp4ikegt worker2 Ready Active 20.10.13

A la fin de cette opération, on a donc obtenu un swarm constitué d'un manager et de plusieurs workers comme, par exemple, l'infrastructure de développement du portail. Pour une infrastructure à plusieurs managers, il reste à promouvoir les managers supplémentaires.

Promotion d'un worker en manager (optionnel)

Dans ce scénario, on ajoute les autres nœuds que le manager1 en tant que worker du swarm avec la commande affichée par docker swarm join-token worker :

# Afficher la commande à exécuter sur les workers

docker swarm join-token worker

# Retourne une commande du type à exécuter sur chacun des noeuds worker

docker swarm join --token <UN_LONG_TOKEN> <IP_DU_MANAGER>:2377

Note : ports Docker

- 2376 : port de l'API Docker

- 2377 : port de l'API Docker Swarm

- 5000 : port du registry Docker (machine de build)

L'état du swarm est alors le suivant :

# Afficher l'état du cluster

docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

kuj58tn3l1ueyuyt4nnjtulip * manager1 Ready Active Leader 20.10.13

0whu7cq053xvrnrrtylrqp52e manager2 Ready Active 20.10.13

k6h1kd3pd8l5ja9o29jhqmnmf manager3 Ready Active 20.10.13

opnn5kj1839pq603m1fbh029i worker1 Ready Active 20.10.13

zqnzuwfmk2argo5eobp4ikegt worker2 Ready Active 20.10.13

Il faut donc promouvoir les nœuds manager2 et manager3 au rôle de manager du swarm. Il suffit pour cela d'exécuter la commande docker promote <NODE> pour chacun de ces nœuds sur le premier manager :

# Promouvoir les autres managers

docker node promote manager2

docker node promote manager3

Il suffit alors de vérifier l'état du swarm avec docker node ls :

# Vérifier l'état du cluster

docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

kuj58tn3l1ueyuyt4nnjtulip * manager1 Ready Active Leader 20.10.13

0whu7cq053xvrnrrtylrqp52e manager2 Ready Active Reachable 20.10.13

k6h1kd3pd8l5ja9o29jhqmnmf manager3 Ready Active Reachable 20.10.13

opnn5kj1839pq603m1fbh029i worker1 Ready Active 20.10.13

zqnzuwfmk2argo5eobp4ikegt worker2 Ready Active 20.10.13

Remarque sur le statut de Leader des managers

Le Leader est le nœud manager qui a été élu comme référence pour l'état du swarm. Ce Leader n'est pas nécessairement le premier manager ajouté. Cela dépend du consensus trouvé entre les managers.

Par exemple, après un redémarrage des daemon docker sur les hôtes, le statut de Leader a été attribué au manager2 :

# Vérifier l'état du cluster

docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

kuj58tn3l1ueyuyt4nnjtulip * manager1 Ready Active Reachable 20.10.13

0whu7cq053xvrnrrtylrqp52e manager2 Ready Active Leader 20.10.13

k6h1kd3pd8l5ja9o29jhqmnmf manager3 Ready Active Reachable 20.10.13

opnn5kj1839pq603m1fbh029i worker1 Ready Active 20.10.13

zqnzuwfmk2argo5eobp4ikegt worker2 Ready Active 20.10.13

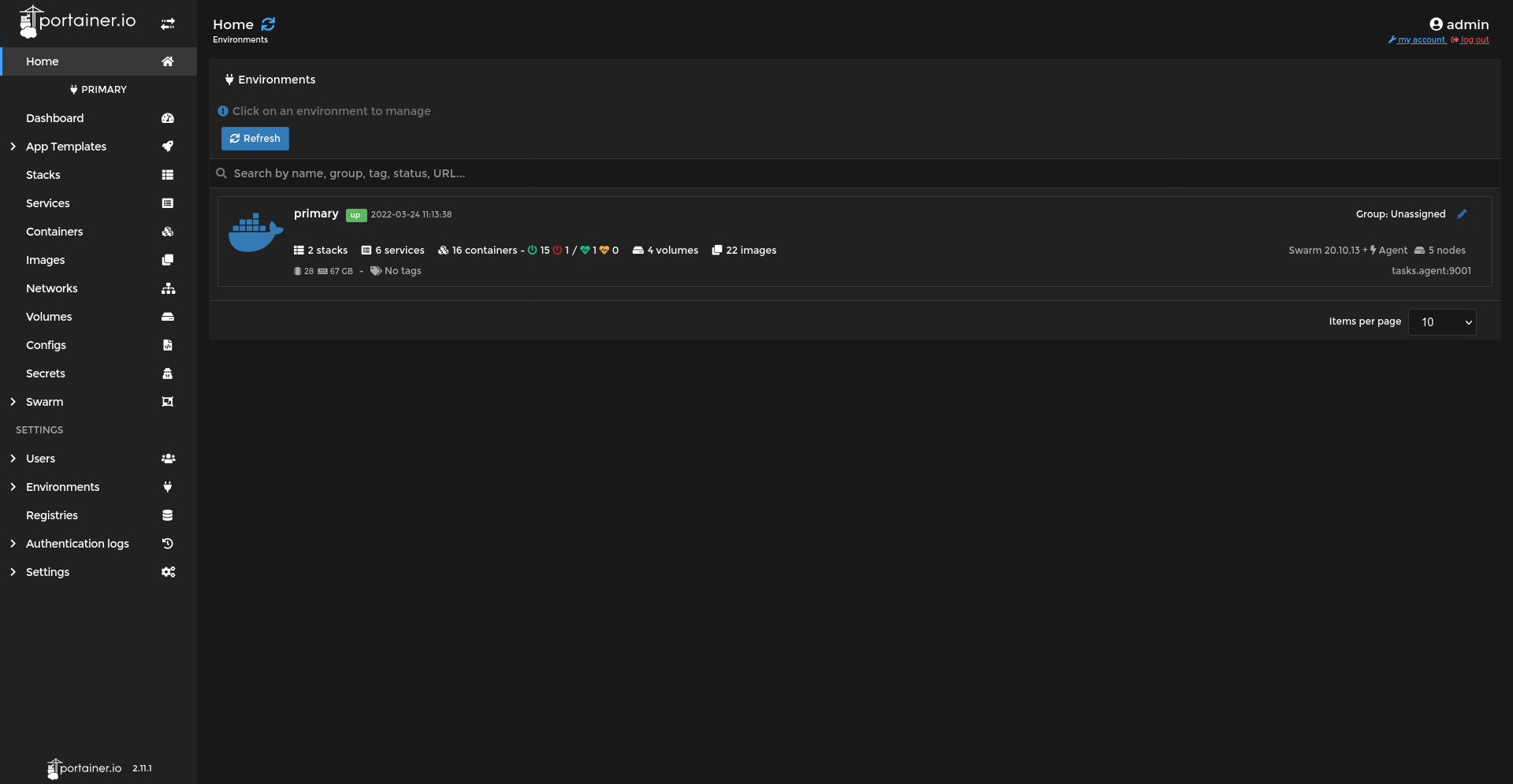

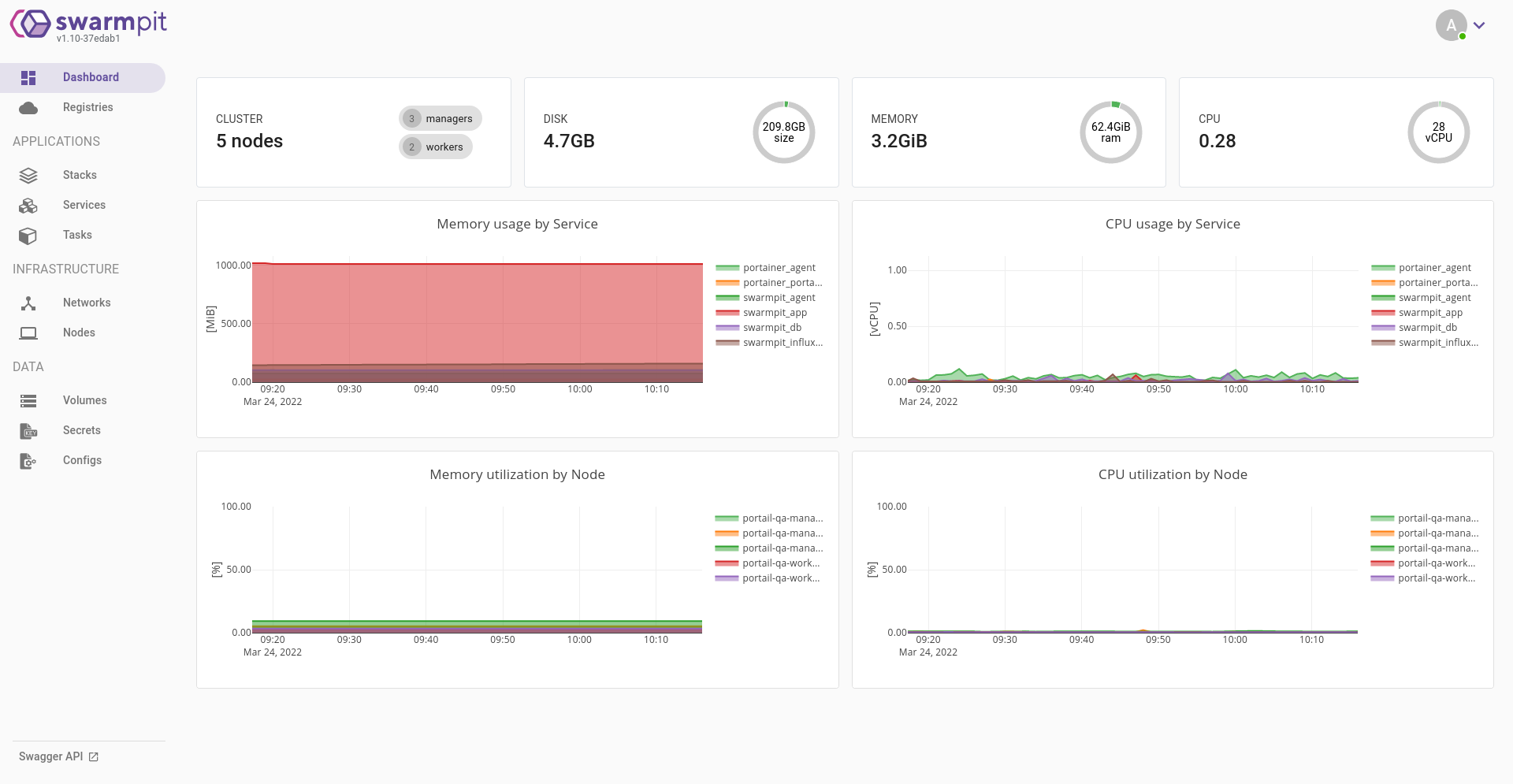

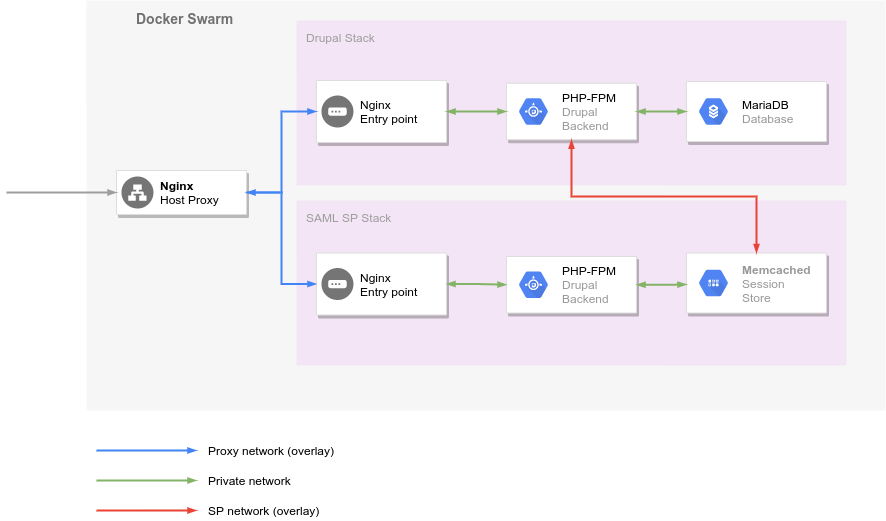

Déploiement des applications nécessaires au fonctionnement et à la gestion du swarm

Déploiement des 3 applications suivantes :

- Registry Docker

- Portainer

- Swarmpit

Registry

Le Registry Docker permet de stocker et de distribuer les images Docker "maison" au sein du swarm. Il se déploie sous la forme d'un simple conteneur :

# Déploiement du registry sur le manager1

docker run -d -p 5000:5000 --restart=always --name registry registry:2

Le Registry sera accessible via http://<ip du manager1>:5000.

Ne pas oublier le --restart=always sans quoi le registry ne redémarrera pas automatiquement avec sa machine hôte...

Configuration des hôtes dans /etc/hosts sur les noeuds du cluster afin d'utiliser le même hôte sur toutes les machines

# Ajouter

<IP DU REGISTRY> private-registry

Et dans le fichier /etc/docker/daemon.json ajouter une entrée pour le registry afin d'autoriser celui-ci sur les machines du swarm :

{

/* ... */

"insecure-registries" : [ "private-registry:5000" ]

}